当AI遇到狗年,说一说用深度学习识别不同品种的狗子

新的一年即将到来了,这里先祝各位新年快乐,狗年财运旺旺的 。在新年的最后一篇推送中,就简单的介绍一下和狗相关的一项黑科技,狗练识别。

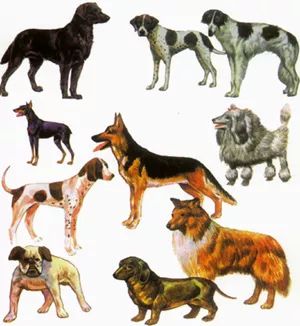

狗是已知的,人类最早驯化的动物了,早在一万五千多年之前,还处在农业时代之前的原始人类就靠着几根骨头骗到了贪吃的灰狼,又等到了农业时代,人们发现狗真的是十项全能的好帮手,于是开始了对狗的定向演化,于是就有了许多看起来差异巨大的不同品种的狗,下图所展示的只是一些常见的品种,你认出那些你熟悉的品种了吗?

而根据不同品种的狗狗的照片,按照品种进行分类,在机器视觉中属于Fine-grained classification,也就是根据图像的细节进行分类,类似的问题还包括根据植物的照片判断是那种花等,你也许会说,这样的问题不应该很简单吗,用深度学习就行了,一层不行就再加一层。

且慢,让我们先看看这个问题本身有那些本质的困难之处。首先是不同品种的狗都很相似,比如下图的三种狗,若你不是狗专家,你能够分清楚吗?

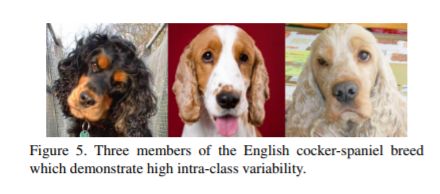

第二个问题是即使是同一种狗,也会差距很大,例如下图的三种狗,竟然是一家人,你说这叫AI头大不头大。

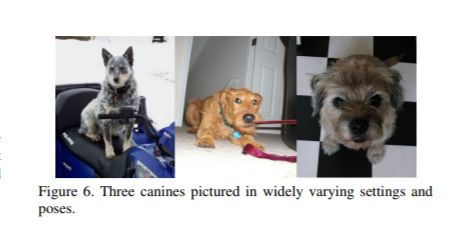

更要命的是不同的狗狗都有各自独特的pose,而且他们所在的图片的区域,图片背后的背景是草地还是森林都不同。下图展示了三只不同姿势的狗狗。

正是由于有这三个问题,要做好狗脸识别,并不是一件简单的事。所以说,使用深度学习去解决具体问题,需要先调研清楚这个问题的背景和障碍,才能够便于设计下一步具体优化方法。

该怎么做了?第一种思路是数据增强,也就是用随机应对随机。既然狗子的位置在照片中不固定,那就将原始的图片随机的裁剪一下,旋转一下,将图像的颜色做一些微调,总之就是想象一个熊孩子打开ps修改了每张狗子的照片,给你留下了一堆看起来和原始的训练数据差不多的照片作为新的训练集。下面给出了随机剪裁之后得到的狗的照片示例。

而另一种方式,可以看成是用有序来应对随机,也就是先通过识别出狗子所在的区域,再将这个区域拉伸成一样大小的图片,来去除背景的干扰。例如下图所示,展示了经过了背景去除和拉伸前后的狗子的照片,可以看到经过处理后的照片,只剩下了我们关心的狗子的信息。

接下来的问题是狗子的照片不够多,斯坦福大学针对狗的品种识别,搞出了一个数据库,里面有一百多种狗,一共一万多张照片,但若是指望这些图片就能够训练出一个靠谱的深度神经网络,那效果多半不好。数据增强虽然能够改善预测的准确性,但其上限不高,毕竟原始的信息就那么多。

若是你自己做不到,不妨站在巨人的肩膀上。迁移学习正是这样,深度学习的好处是模型不再是铁板一块,而是可以拆解成一层一层的,不用花一分钱,你可以拿大牛们训练好的网络,将其用做自己的用途。关于迁移学习,曾经写过一篇名叫的小文,感兴趣的可以点击深入了解。

而迁移学习迁移的是什么样的神经网络,自然是深度学习中最出名的卷积神经网络,关于这个话题,可以参考和,这里就不再重复了。

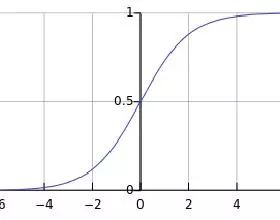

但迁移学习并不意味着什么都不需要来做,你需要利用成熟的网络提取出的高级特征,用他们来进行预测,但是要注意的是,你预测得出的结果并不是一个确定的狗的品种,而是这个图属于哪个品种的概率,而这又是怎么得出来的,靠的是一个名叫softMax的激活函数,这可是深度学习中最出名的两个激活函数了,soft是保证输出的结果是符合概率分布,也就是不会出现概率为120%的情况,而max是让错的更错,从而提高学习的效率。

最后说一说这个例子的实现难度,类似Minst数据集的手写数字识别,宠物狗的品种分类,也是一个相对容易上手的例子,你不需要昂贵的显卡,就普通的个人电脑,就可以基于已有的图像识别网络,例如谷歌的Inception,来搭建一个属于你的狗脸识别程序。除了用来展示,这个例子还可以锻炼你诊断网络的能力,训练的太慢,不妨换换更快学习率,训练的结果起伏太大,还可以再换换更慢的学习率啦。

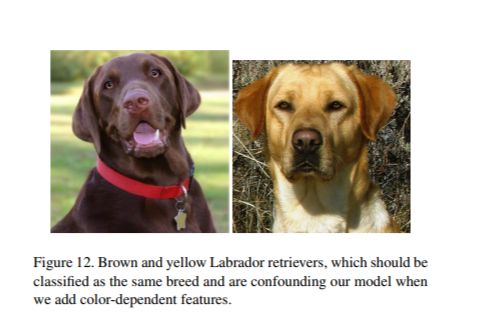

开个玩笑,虽然学习率是深度学习中很重要的一个参数,但不是万能的,这个例子的好处是让你能够直观的看到你训练出神经网络有那些不足,又为什么会犯错,例如下图,如果是将图片变成黑白的,神经网络是不会犯错的,但一旦加上了色彩,你就会发现神经网络没有将黄色那只分成拉布拉多犬,这时你就能发现,是你的神经网络过拟合了,网络中的一个神经元学到的速记口诀,但凡黄色的都不是拉布拉多,这时不管你怎么做数据增强,对数据又拉伸又旋转,都无法教会这个神经元忘掉这个口诀,这也是我为什么上文说数据增强的效果是有上限的。

而这时如果你能用dropout机制,时不时的将这个背小抄的神经元踢下线,那么你的神经网络就能够有机会学到拉布拉多真正的特征,这也就解释了为什么dropout机制是一种极为高效的防止模型过拟合的方法。